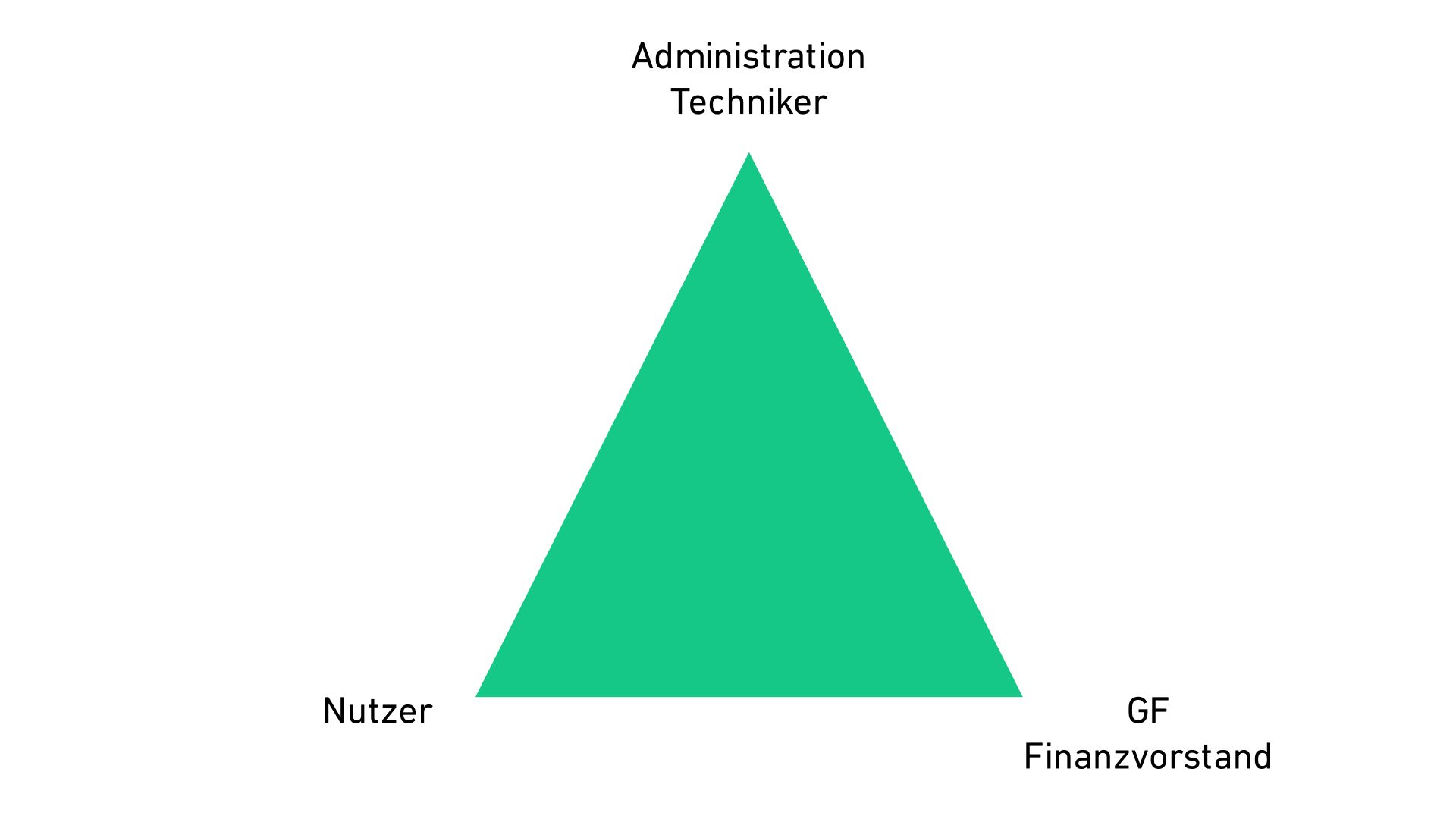

Die Speichersysteme fast aller IT-Umgebungen in Unternehmen erfüllen nur selten die Erwartungen oder Anforderungen aller seiner Endnutzer, Administratoren und Finanzverantwortlichen. Drei große Herausforderungen gehen einher mit der Anschaffung und dem Betrieb einer Storageumgebung. Kompromisse zwischen Preis, Leistung und Funktionen sind der Standard. Die umgesetzten Lösungen stellten aber immer nur maximal ein bis zwei angesprochenen Parteien überhaupt zufrieden, mindestens eine beteiligte Gruppe blieb auf der Strecke, daher das Bild des Trilemmas. Es geht auch anders, mit virtualisierten Speicherclustern und Software-Defined-Storages (SDS).

Mit der Einführung von bisherigen Storage Area Networks (SAN), wurde die klassische Datenverarbeitungslandschaft zwischen Server und Speicher aufgeteilt und über ein dediziertes Netzwerk, dem SAN, wieder miteinander verknüpft. Vorher waren mehrere Festplatten direkt in die Server eingebaut oder angeschlossen. Die ersten Generationen der vernetzten Storages, meist durch Fibre Channel angebunden, erfüllten nicht die Nutzer-Erwartungen, denn sie hatten wenige Vorteile aber leider viele Nachteile:

- Die Geschäftsführer oder Finanzvorstände waren nicht glücklich, denn diese Systeme waren oft sehr teuer in der Anschaffung und dem Unterhalt.

- Das technische Personal war unzufrieden da diese Lösungen in der Administration entweder zu komplex und fehleranfällig waren, oder im Gegenteil, eine kaum den eigenen Bedürfnissen anpassbare Blackbox darstellte.

- Auch die Nutzer, die mit den Servern und Applikationen arbeiteten, mussten oft eine Verschlechterung der Performance feststellen.

Letztendlich waren oft nur ein oder zwei Gruppen zufrieden mit der neuen Speicherumgebung: Zum Beispiel die Geschäftsleitung und die Nutzer, wenn relativ günstig und dennoch performant eingekauft wurde, aber dann die IT-Abteilung mit unausgereifter Technik kämpft. Oder die IT und auch die Benutzer sich freuten, der Finanzvorstand aber tief in die Tasche greifen musste, da es teuer wurde.

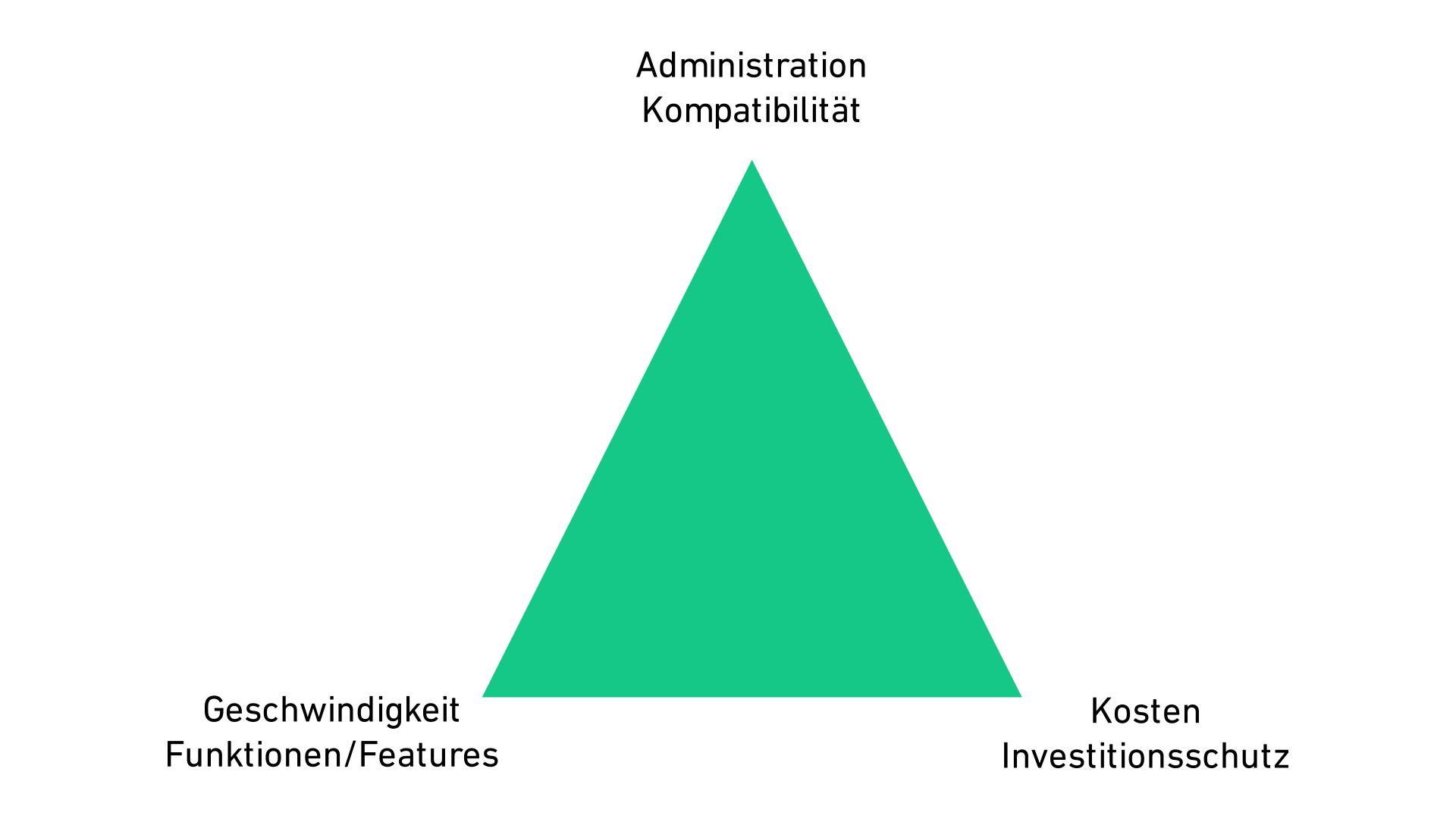

Im Folgenden werden die drei zentralen Aufgaben und Herausforderungen an moderne Speicherarchitekturen beschrieben. Dies betrifft große und kleine Speicherumgebungen, unabhängig von den technischen Anforderungen, den eingesetzten Speichertechnologien oder auch bestimmten Hardwareherstellern.

Die Erfahrung hat gezeigt, dass die meisten Speichersysteme oft schwer und umständlich in der Administration sind. Nur wenige haben grafische Bedienoberflächen, sie sind zumeist nicht in Überwachungssysteme integrierbar und auch der Funktionsumfang ist eingeschränkt. Die verfügbaren Festplattenkapazitäten sind ein großer Block, es gilt ihn in einzelne unflexible Einheiten zu unterteilen und diese Units oder LUNs anschließend verschiedenen Servern statisch zuzuweisen. Diesem Prinzip folgen die teuren Lizenzmodelle der Hersteller. Jede Einheit und jeder Anschluss an ein zugreifendes System, wie ein Anwendungsserver, braucht eine Lizenz. Es spielt keine Rolle, ob es ein virtualisierter VMware Server mit 100 virtuellen Maschinen oder ein einzelner Windows oder Linux Server ist, es gibt keine Flexibilität.

Die Lösung:

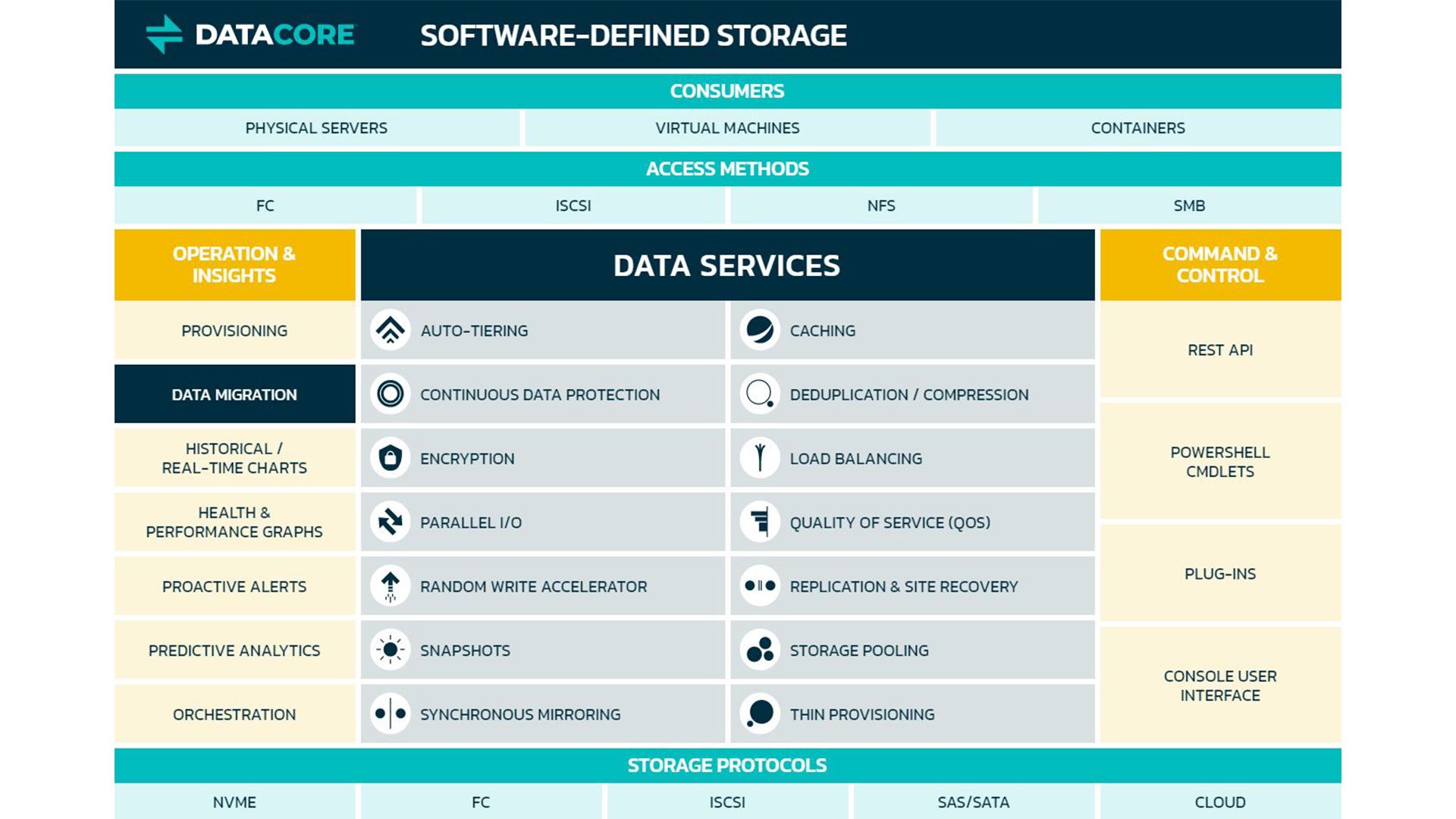

Es wird eine Abstraktionsschicht eingeführt, eine Zwischenschicht beziehungsweise eine Software gestützte Speicher-Virtualisierung (SDS). Ziel ist, die großen Speicherblöcke effizient und einfach verwalten zu können. Intelligente Software steuert nun, was bis dahin in Hardware gegossen war. Viele Funktionen sind nun möglich und können stetig weiterentwickelt werden. Einfache Bedienoberflächen erleichtern die Erstellung und Zuweisung von Speichereinheiten, nehmen die Komplexität und verhelfen zu mehr Übersicht. Inselsysteme, also meist herstellerabhängige Storage-Umgebungen (die damit versuchen ihr "Revier" zu verteidigen), können plötzlich miteinander kombiniert werden.

Nebenbei konnte eine Kernanforderung, die Hochverfügbarkeit und damit die Business Continuity im Fall eines Ausfalls einzelner Infrastrukturkomponenten oder Speichersysteme gewährleistet werden. Die Gefahr eines gestörten Geschäftsbetriebes durch Verlust oder Nichtverfügbarkeit von Daten ist massiv minimiert.

Die durchgehende Transparenz dieser Zwischenschicht bedeutet auch, dass angeschlossene Server wie gewohnt mit deren (virtualisierten) Festplatten arbeiten können. Zusätzlich kann ohne Unterbrechung im Hintergrund zwischen verschiedenen Datenquellen hin- und hergeschaltet werden, wie es beispielsweise bei Wartungsarbeiten notwendig ist. Downtimes der IT-Landschaften gehören damit der Vergangenheit an.

Auch Replikationen von Datenbeständen am eigenen Firmenstandort in andere Brandabschnitte oder in andere Unternehmensstandorte sind kein Problem.

Viele haben die Befürchtung, dass eine Virtualisierung von Speichern die Performance negativ beeinflussen könnte. Neben der Verfügbarkeit sind schnelle Reaktionszeiten von Anwendungen und Datenbanken eine weitere Kernanforderung. Langsame Zugriffsgeschwindigkeiten sind ein No-Go.

Verschiedenste neue Anforderungen werden aus unterschiedlichsten Gründen gestellt und müssen erfüllt werden, Tiering von Daten (kalter Speicher, heißer Speicher), Datenverschlüsselung, Snapshots, Quality of Service, Replications & Site Recovery, Thin Provisioning und Deduplizierungen.

Die Lösung:

Einzig durch Software gesteuerte Caches, also Zwischenspeicher, wird die Geschwindigkeit um ein Vielfaches verbessert. Durch eine Aufgaben-Parallelisierung wie in modernen Softwarearchitekturen üblich, wird der immer noch vorherrschende Ansatz der Serialisierung von Hardwaresystemen aufgebrochen.

Caching und Parallelisierung im Zusammenspiel ergeben eine enorme Leistungssteigerung. Gesteigerte Performancerates um den Faktor 10 können oft beobachtet werden!

Bemerkenswert: Wenn gewünscht, wird im Hintergrund weiterhin mit der bereits vorhandenen Storage-Hardware gearbeitet. Diese ist mit Intelligenz angereichert und kann so wesentlich effizienter genutzt werden.

Auch was die Features angeht, spielt die Software als verwaltende Instanz seine Stärken aus und erfüllt diese umfassend. Denn die aufgezählten Funktionen haben nichts mit der Hardware zu tun. Für die SSD, SAS/SATA Festplatte oder Cloudspeicher ist die Funktionsanforderung unerheblich, es geht um die agile und dynamische Steuerung von Daten auf Datenträgern, nicht die Hardware an sich.

Finanzverantwortliche stehen vor großen Herausforderungen: Speichersysteme sind in der Anschaffung und dem Betrieb sehr teuer. Fortlaufend braucht es mehr Budget für Speichererweiterungen, da das Datenwachstum nur eine Richtung kennt: nach oben. Der gefürchtete Vendor Lock-in bindet ein Unternehmen meist viele Jahre an einen bestimmten Hersteller. Ein Beispiel: Eine herstellergebundene normale Festplatte kostet nicht selten 3mal so viel wie die gleiche Festplatte auf dem freien Markt. Hat man bestimmte Kapazitätsanforderungen überschritten, ist es auch nicht immer mit einer Erweiterung getan. Es geht schlicht nicht oder ist nicht erlaubt. Man kauft dann ein komplett neues, größeres Modell eines Speicherclusters, unabhängig von der alten Hardware.

Die Lösung:

Durch die bereits beschriebene Abstraktionsschicht von Speicher, werden die Grenzen der physikalischen Einheiten aufgehoben und die Abhängigkeit von einzelnen Herstellern wird gänzlich aufgebrochen. So können jederzeit nach Bedarf Kapazitäten oder Hardware eingekauft werden, die aktuell am kosteneffizientesten sind. Vorhandene Systeme können im Sinne eines Investitionsschutzes einfach weiter genutzt werden, oft auch länger als üblich, da eine gesteigerte Leistung erzielt wurde. Auch ein präventiver Austausch aus Angst vor "alter" Hardware kann vertagt werden, dem Feature Hochverfügbarkeit sei Dank.

Effekte wie eingesparte Schulungs- & Zertifizierungskosten für das technische Personal spielen ebenfalls eine Rolle.

Verschiedene Lizenzmodelle werden möglich: Einmalige und wiederkehrende Kosten werden mit relevanten und planbaren Kennzahlen, wie dem aktuellen Festplattenverbrauch der IT-Landschaften, verknüpft. Damit sind Performance- und Kapazitäts-Kalkulationen über Jahre hinweg nicht mehr nötig. Auch flexible Mietmöglichkeiten, sogar auf monatlicher Abrechnungsbasis und aufgrund von wirklich genutzten Ressourcen, inkl. Hardware, sind denkbar. Damit könnte man auch von Capex in Opex Budgets wechseln.